Quinta-feira, 06 de Março de 2025

Quinta-feira, 06 de Março de 2025

Por Redação Rádio Pampa | 5 de março de 2025

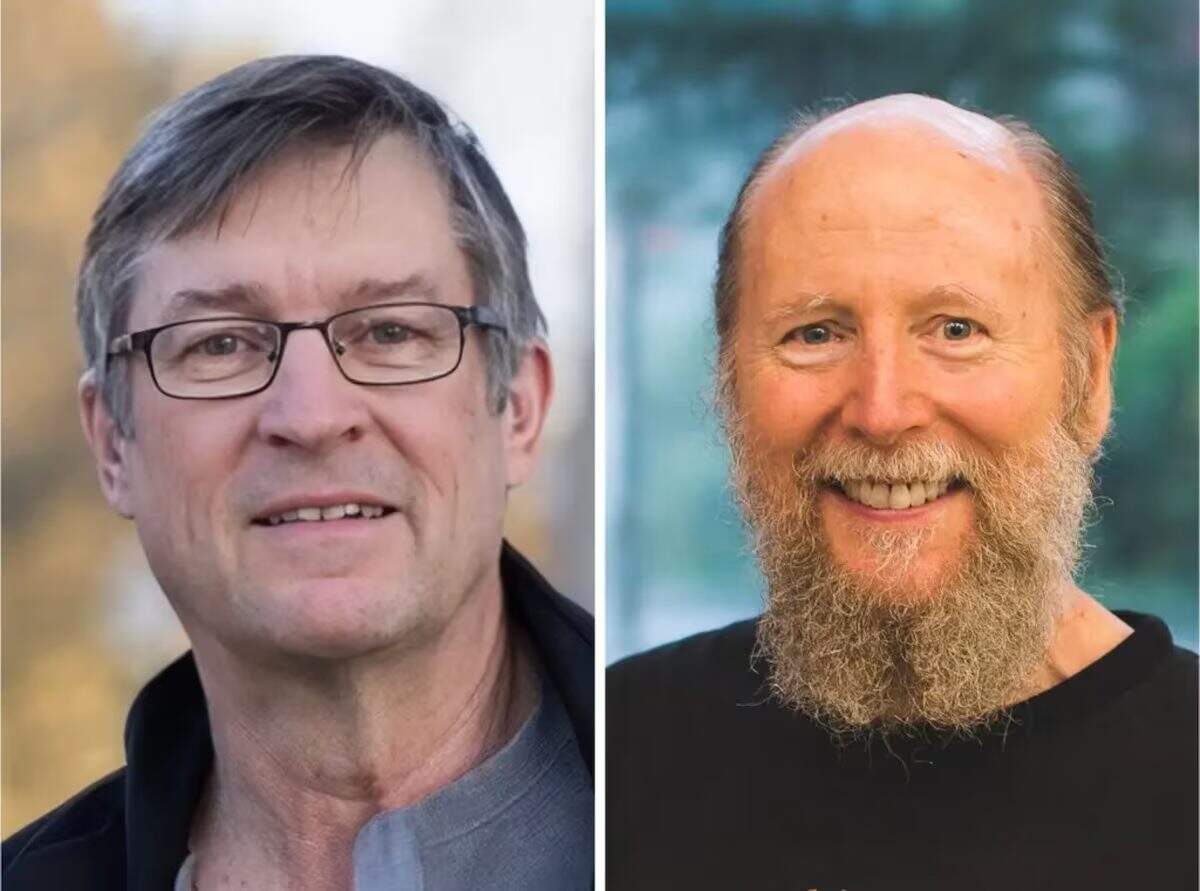

Em 1977, Andrew Barto, então pesquisador da Universidade de Massachusetts em Amherst, começou a explorar uma nova teoria de que os neurônios se comportavam como hedonistas. A ideia básica era que o cérebro humano era movido por bilhões de células nervosas que tentavam maximizar o prazer e minimizar a dor.

Um ano depois, ele foi acompanhado por outro jovem pesquisador, Richard Sutton. Juntos, eles trabalharam para explicar a inteligência humana usando esse conceito simples e o aplicaram à inteligência artificial (IA). O resultado foi o “aprendizado por reforço”, uma maneira de os sistemas de inteligência artificial aprenderem com o equivalente digital do prazer e da dor.

Nesta quarta-feira, 5, a Association for Computing Machinery, a maior sociedade de profissionais de computação do mundo, anunciou Barto e Sutton ganharam o Prêmio Turing deste ano por seu trabalho sobre aprendizagem por reforço. O Prêmio Turing, que teve início em 1966, é frequentemente chamado de Prêmio Nobel da computação. Os dois cientistas dividirão o prêmio de US$ 1 milhão que acompanha o prêmio.

Na última década, o aprendizado por reforço desempenhou um papel fundamental no crescimento da inteligência artificial, incluindo tecnologias revolucionárias como o AlphaGo do Google e o ChatGPT da OpenAI. As técnicas que impulsionaram esses sistemas foram baseadas no trabalho de Barto e de Sutton.

“Eles são os pioneiros indiscutíveis do aprendizado por reforço”, diz Oren Etzioni, professor emérito de ciência da computação da Universidade de Washington e diretor executivo fundador do Allen Institute for Artificial Intelligence. “Eles geraram as principais ideias e escreveram o livro sobre o assunto.”

O livro, Reinforcement Learning: An Introduction (Aprendizado por reforço: uma introdução, em tradução livre), publicado em 1998, continua sendo a exploração definitiva de uma ideia que, segundo muitos especialistas, está apenas começando a realizar seu potencial.

Os psicólogos há muito tempo estudam as maneiras pelas quais os seres humanos e os animais aprendem com suas experiências. Na década de 1940, Alan Turing, o pioneiro cientista da computação britânico, sugeriu que as máquinas poderiam aprender da mesma forma.

Mas foram Barto e Sutton que começaram a explorar a matemática de como isso poderia funcionar, com base em uma teoria proposta por A. Harry Klopf, um cientista da computação que trabalhava para o governo dos EUA. Barto construiu um laboratório em Amherst dedicado a essa ideia, enquanto Sutton fundou um laboratório semelhante na Universidade de Alberta, no Canadá.

“É uma ideia meio óbvia quando se trata de seres humanos e animais”, diz Sutton, que também é cientista pesquisador da Keen Technologies, uma startup de IA, e bolsista do Alberta Machine Intelligence Institute, um dos três laboratórios nacionais de IA do Canadá. “Quando o revivemos, era sobre máquinas.”

Isso continuou sendo uma busca acadêmica até a chegada do AlphaGo em 2016. A maioria dos especialistas acreditava que passariam mais 10 anos até que alguém construísse um sistema de IA capaz de vencer os melhores jogadores do mundo no jogo de Go.

Mas durante uma partida em Seul, na Coreia do Sul, o AlphaGo venceu Lee Sedol, o melhor jogador de Go da última década. O truque foi o fato de o sistema ter jogado milhões de partidas contra si mesmo, aprendendo por tentativa e erro. Ele aprendeu quais movimentos traziam sucesso (prazer) e quais traziam fracasso (dor).

A equipe do Google que criou o sistema foi liderada por David Silver, um pesquisador que havia estudado a aprendizagem por reforço com Sutton na Universidade de Alberta.

Muitos especialistas ainda questionam se o aprendizado por reforço poderia funcionar fora dos jogos. Os prêmios dos jogos são determinados por pontos, o que torna fácil para as máquinas distinguirem entre sucesso e fracasso.

Mas o aprendizado por reforço também tem desempenhado um papel essencial nos chatbots inteligentes.

Antes do lançamento do ChatGPT em novembro de 2022, a OpenAI contratou centenas de pessoas para usar uma versão inicial e fornecer sugestões precisas que poderiam aprimorar suas habilidades. Elas mostraram ao chatbot como responder a perguntas específicas, avaliaram suas respostas e corrigiram seus erros. Ao analisar essas sugestões, o ChatGPT aprendeu a ser um chatbot melhor.

Os pesquisadores chamam isso de “aprendizado por reforço a partir de feedback humano”, ou RLHF, na sigla em inglês. E esse é um dos principais motivos pelos quais os chatbots atuais respondem de forma surpreendentemente realista.

Mais recentemente, empresas como a OpenAI e a startup chinesa DeepSeek desenvolveram uma forma de aprendizagem por reforço que permite que os chatbots aprendam com eles mesmos, como fez o AlphaGo. Ao trabalhar com vários problemas de matemática, por exemplo, um chatbot pode aprender quais métodos levam à resposta correta e quais não levam.

Se esse processo for repetido com um conjunto muito grande de problemas, o bot pode aprender a imitar a maneira como os humanos raciocinam – pelo menos em alguns aspectos. As informações são do portal Estadão.

No Ar: Pampa Na Madrugada